【TDengine 使用环境】

测试环境

【TDengine 版本】

3.3.7.5-开源版

【操作系统以及版本】

centos 7.6

【部署方式】容器/非容器部署

k8s 官方 helm 部署

k8s版本:v1.23.17

【集群节点数】

3

【集群副本数】

3

【描述业务影响】

【问题复现路径/shan】做过哪些操作出现的问题

- 部署了3台节点,3台dnode都作为mnode

- 此时有1台leader,2台follower

- 对其中一台follower执行delete pod操作

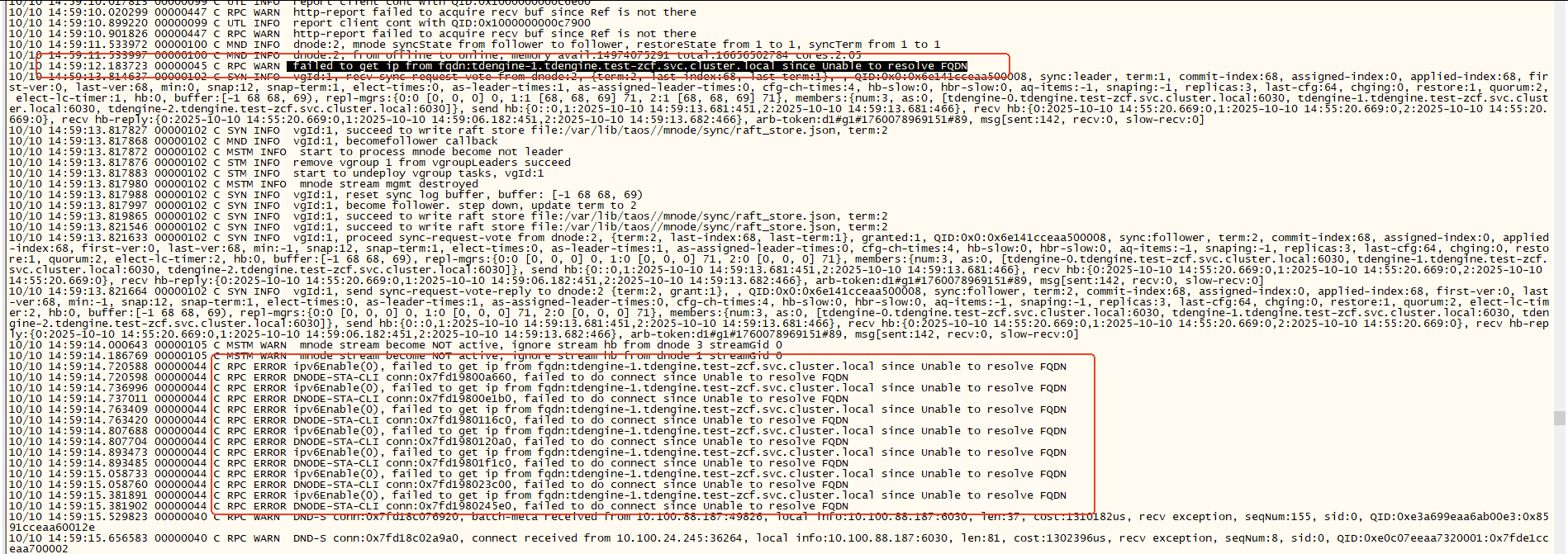

- 被delete的节点重新加入集群,但是此时leader节点会报错: failed to get ip from fqdn tdengine-0.test-zcf.svc.cluster.local since unable to resolve fqdn,大概会持续5s,可能是因为k8s重新恢复pod导致的ip切换?

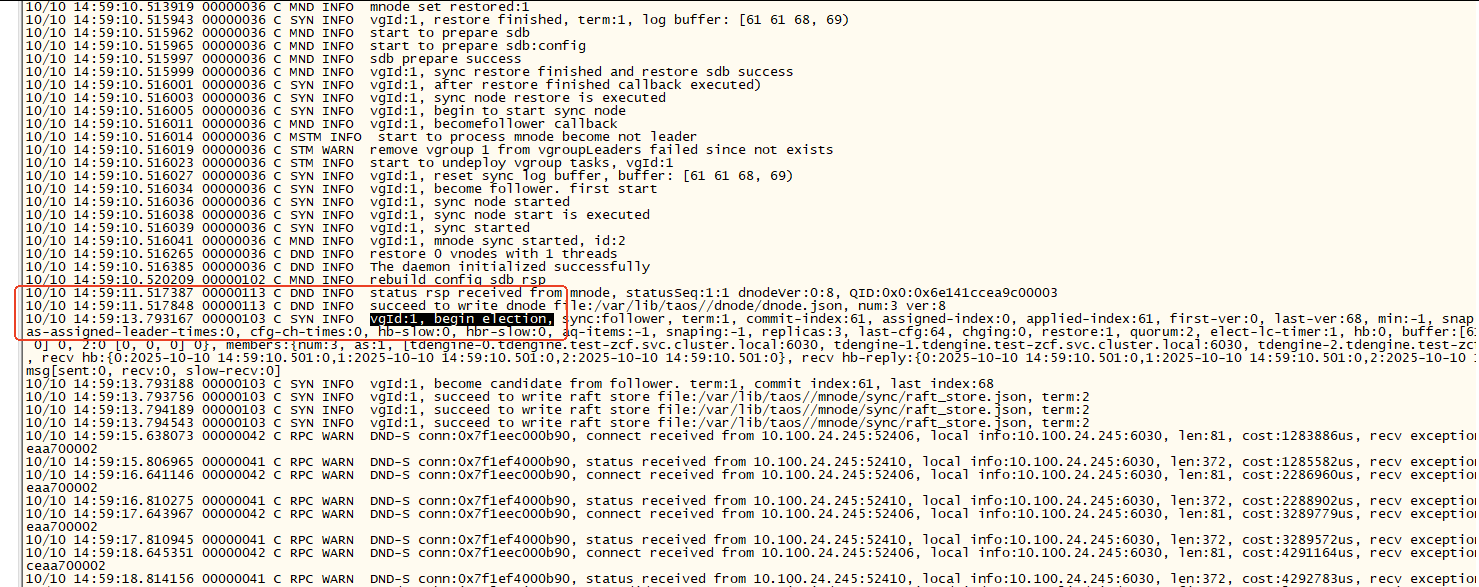

- 此时由于重新加入集群的节点在3s内没有建立与mnode的通信(不知道我理解的对不对),所以重新发起选举;

- 这样就会导致整个集群会重新进行raft选举,持续时间10-60s不等,这段时间内集群无法正常进行访问。

【遇到的问题:问题现象及影响】

目前mnode从节点挂掉也会导致整个集群重新进行选举,访问不可达

【希望单个节点宕机不影响3个节点集群的稳定性】

【资源配置】

【报错完整截图】

leader节点